Scuola: il bonus della discordia

Da quest’anno, un ottimo voto alla maturità permette di aggiungere punti ai risultati conseguiti nei test di ingresso alle facoltà a numero chiuso. Ma come evitare le ingiustizie? Meglio basarsi sulla performance assoluta dello studente o su quella relativa ai suoi pari? O affidarsi solo ai test?

di Massimiliano Bratti, La Voce.info 7.6.2013

A partire da

quest’anno, l’ex ministro dell’Istruzione Francesco Profumo ha

previsto un “bonus-maturità’’:

fino a un massimo di 10

punti, da attribuire

ai diplomati che abbiano conseguito almeno un punteggio di 80

centesimi nell’esame finale, che vanno a sommarsi ai punti

conseguiti nei test di ingresso per i corsi universitari a numero

chiuso.

Il bonus, però, viene attribuito allo studente sulla base della sua

posizione rispetto ai percentili dei voti all’interno della sua

scuola: il fatto che uno

studente sia nel 95mo percentile indica per esempio che appartiene

al 5 per cento degli studenti con punteggi più alti dell’istituto.

Il bonus viene quindi assegnato sulla base dei

risultati relativi

degli studenti rispetto a quelli dei pari nelle stesse scuole. Il

criterio potrebbe dunque far sì che studenti della stessa città, ma

provenienti da scuole diverse, pur con lo stesso voto di diploma

conseguano bonus di entità diversa: questa osservazione ha suscitato

una certa dose di critiche, per il rischio di ingiustizie che ciò

genererebbe. Ma un bonus che riflettesse delle “performance

assolute” e non relative. ovvero un bonus

uguale per tutti

gli studenti con lo stesso punteggio di diploma a prescindere dalla

scuola da cui provengono, basato ad esempio sui quantili calcolati a

livello nazionale, offrirebbe forse la garanzia di essere “giusto”?

I TEST STANDARDIZZATI

Mettiamoci nei

panni di un’università

che voglia selezionare gli studenti nei corsi a numero chiuso e

vediamo quali sono le opzioni disponibili.

Una possibilità è certamente quella di utilizzare dei

test

standardizzati. Hanno il vantaggio di essere gli stessi per tutti

coloro che li sostengono, e pertanto consentono di valutare gli

studenti utilizzando lo stesso “metro” di misura. Tuttavia,

presentano anche dei limiti. Innanzitutto sono

costosi, soprattutto se diversi test devono essere utilizzati in

diverse discipline. E dato che non è possibile testare tutte le

conoscenze in possesso dagli studenti utilizzando un numero limitato

di quesiti e che il risultato degli studenti nei test potrebbe

essere influenzato da fattori di breve-periodo (ad esempio lo stato

psico-fisico durante il test), molte università ritengono utile

integrarli con un bonus

calcolato sulla base del

voto di diploma.

Bonus che può essere attribuito sulla base della performance

assoluta dello studente oppure sulla base della sua performance

relativa.

VOTO DI MATURITÀ E TEST D’INGRESSO

Mettiamoci nei

panni di un’università

che voglia selezionare gli studenti nei corsi a numero chiuso e

vediamo quali sono le opzioni disponibili.

Una possibilità è certamente quella di utilizzare dei

test

standardizzati. Hanno il vantaggio di essere gli stessi per tutti

coloro che li sostengono, e pertanto consentono di valutare gli

studenti utilizzando lo stesso “metro” di misura. Tuttavia,

presentano anche dei limiti. Innanzitutto sono costosi, soprattutto

se diversi test devono essere utilizzati in diverse discipline. E

dato che non è possibile testare tutte le conoscenze in possesso

dagli studenti utilizzando un numero limitato di quesiti e che il

risultato degli studenti nei test potrebbe essere influenzato da

fattori di breve-periodo (ad esempio lo stato psico-fisico durante

il test), molte università ritengono utile integrarli con un bonus

calcolato sulla base del

voto di diploma.

Bonus che può essere attribuito sulla base della performance

assoluta dello studente oppure sulla base della sua performance

relativa.

BONUS BASATO SULLA PERFORMANCE ASSOLUTA

Il bonus basato

sulla performance assoluta è quello richiesto dai critici del

“premio” pensato da Profumo. In base a questa idea, gli studenti con

lo stesso voto

di diploma dovrebbero

conseguire lo stesso

bonus

(al massimo con una correzione

relativa alla città o alla regione di residenza). Il criterio di

uguaglianza formale rispetterebbe anche un criterio di uguaglianza

sostanziale? Nell’ambito dell’economia dell’istruzione, ma anche di

altre discipline (sociologia, pedagogia), ci si è già ampiamente

occupati del fenomeno della cosiddetta

grade inflation,

o “inflazione dei voti”.

È la tendenza che potrebbero avere certi docenti o scuole a

attribuire voti più o meno alti a studenti con lo

stesso livello

di conoscenze o preparazione. Il fenomeno è stato già osservato nei

dati del Programme

for International Student Assessment

dell’Ocse.

Il vantaggio offerto dal

test Pisa

è che è basato su un test

standardizzato che misura le competenze degli studenti. Pur con i

suoi limiti, si tratta di un raro caso in cui si ha la possibilità

di confrontare tra scuole e regioni la corrispondenza tra le

valutazioni interne degli insegnanti e il livello di competenze

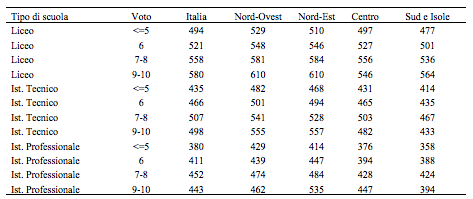

degli studenti. Nella tabella 1 abbiamo riportato i livelli medi di

capacità in lettura (reading

literacy) degli studenti

misurato in Pisa 2009 corrispondenti a diverse fasce di voto

attribuito agli studenti dai propri insegnanti. Sono state riportate

le medie per tipo di scuola e per macro-area geografica. È evidente

che alla stessa fascia di voto corrispondono livelli di competenze

molto diversi. Negli istituti tecnici e professionali addirittura le

competenze medie di coloro che riportato voti di 9 e 10 risultano

più basse di quelle di coloro che hanno valutazioni di 7 o 8 al

liceo (il fenomeno è trainato dal Centro e Sud), il che mostra

chiaramente che in certe scuole gli insegnanti sono

più generosi

nei voti (grading

standard). Un bonus uguale

per tutti non offrirebbe pertanto sufficienti garanzie di

“giustizia”.

Tabella 1. Medie dei punteggi Pisa in lettura (2009) per tipo di scuola, classe di voto e macro-area

ONUS BASATO SULLA PERFORMANCE RELATIVA

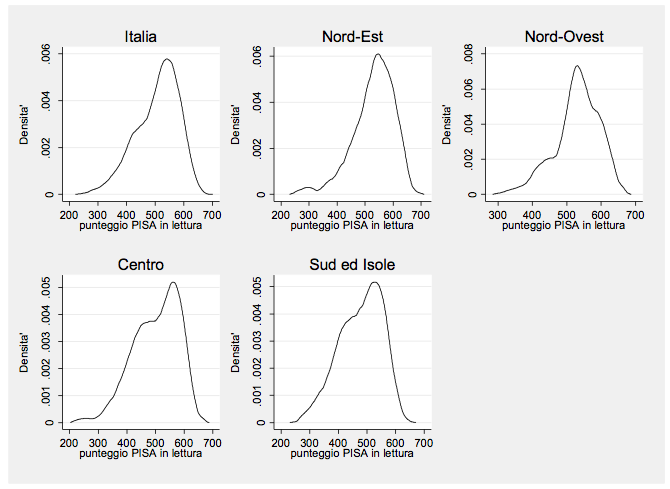

È da qui che chiaramente trae origine la soluzione introdotta da Francesco Profumo. Un bonus basato su performance assolute potrebbe creare incentivi avversi per le scuole, che avrebbero l’interesse ad alzare le valutazioni dei propri studenti per aumentarne la probabilità di accettazione nei corsi a numero chiuso. Ciò produrrebbe necessariamente un gonfiamento del livello dei voti (grade inflation) a livello di intero sistema scolastico, perché nessuna scuola vorrebbe rimanere indietro. Se il il bonus è basto sulla performance relativa, l’incentivo viene a mancare: anche alzando i voti di tutti gli studenti (nella stessa misura), la posizione relativa all’interno della scuola non cambia. Vediamo allora, sempre attraverso i dati Pisa, se questo criterio garantisce una migliore corrispondenza tra ranking dello studente e livello di conoscenze. Nella figura 1 è stata riportata la distribuzione dei punteggi Pisa per livello di scuola per il quartile più elevato del voto attribuito dai docenti misurato a livello di singola scuola. Abbiamo considerato solo le scuole con almeno dieci studenti. Idealmente vorremmo una distribuzione molto concentrata (ovvero poche differenze tra scuole), ma la figura 1 mostra che non è così, neppure all’interno delle quattro macro-aree geografiche. Quindi anche questo criterio preso da solo non funziona.

Figura 2. Distribuzione dei punteggi medi Pisa (2009) in lettura per scuola, per gli studenti nel quartile più elevato del voto degli insegnanti

IL “PECCATO ORIGINALE”

L’errore principale del bonus così come pensato dall’ex-ministro

Profumo è che si basa sull’ipotesi che gli studenti si

distribuiscano in maniera casuale tra le diverse

scuole. Soltanto in questo caso infatti degli indicatori di

performance relativi misurano anche in media la performance assoluta

degli studenti. Ciò evidentemente non funziona in un sistema come

quello italiano, differenziato per indirizzi, in cui gli

studenti scelgono diversi tipi di scuola (licei, istituti tecnici,

istituti professionali) a seconda del loro livello di abilità. In

questo caso, usare degli indicatori basati sulla performance

relativa ha degli esiti paradossali, per cui studenti “bravi” che

hanno compagni altrettanto “bravi” (ovvero con punteggio di diploma

elevato) potrebbero essere svantaggiati nell’attribuzione del bonus.

Nelle analisi sopra riportate abbiamo usato a scopo esemplificativo

i dati Pisa, tuttavia a risultati analoghi si arriva utilizzando

altre misure di performance scolastica. In un recente studio che ho

condotto per la Fondazione Cariplo insieme a

Daniele

Checchi e Antonio Filippin, si è cercato di costruire indici di

performance esterna delle scuole secondarie superiori lombarde sulla

base dei risultati conseguiti dagli studenti che provenendo da

queste scuole si sono iscritti agli atenei lombardi. (1)

Abbiamo considerato quali indicatori di risultato

scolastico il numero di crediti conseguiti e il

voto medio negli esami universitari pesato per il numero di crediti.

L’analisi mostra che voto di diploma, posizione relativa dello

studente all’interno della scuola (percentile di voto di diploma) e

punteggio nel test di ingresso contribuiscono tutti a spiegare in

maniera indipendente il successo degli studenti a

livello di studi universitari. (2)

In conclusione, se proprio devono essere introdotti correttivi al

punteggio dei test di ingresso, questi dovrebbero prendere in

considerazione sia il voto di diploma che la posizione relativa

degli studenti all’interno della propria scuola. Bonus basati su uno

solo dei due elementi rischiano di introdurre più ingiustizie di

quelle che intendono rimuovere.

(1)

Bratti, M., Checchi, D. e Filippin, A.

(2011), “Valore di segnalazione del voto di diploma e grading

standard nelle scuole secondarie superiori”, in Rapporto per la

Fondazione Cariplo. Uno studio analogo esiste anche per il Piemonte:

De Simone, G., Monastero, B. e Stanchi, A. (2009), “Un esercizio di

valutazione esterna: come le università piemontesi giudicano

(indirettamente) le scuole della Regione”, Programma Education

Fondazione Giovanni Agnelli,

Working Paper n. 18.

(2)

Aumenti di una deviazione standard nel

punteggio del test di ingresso e nel voto di diploma sono associati

significativamente ad aumenti di una e di mezza unità (circa),

rispettivamente, nel voto medio pesato per i crediti. L’aumento di

uno nel percentile dello studente è associato invece a un aumento di

mezza unità nello stesso indicatore di performance.